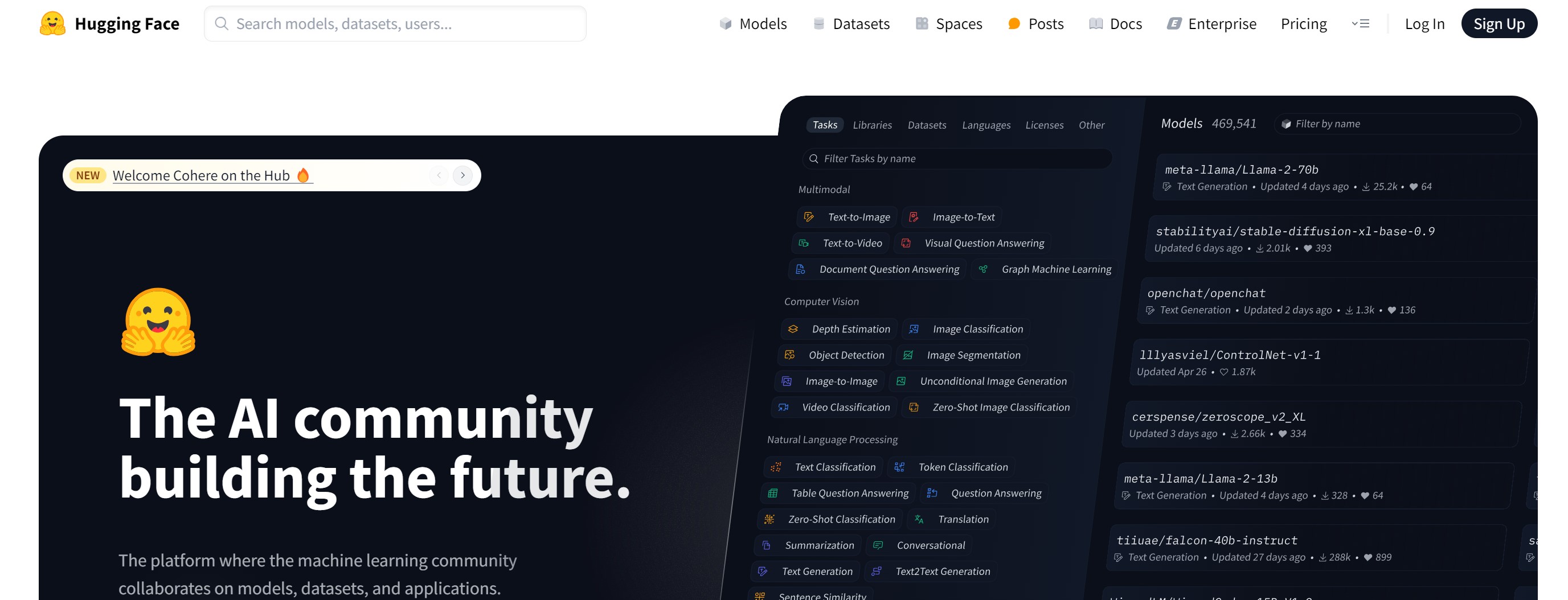

Hugging Face 是什么

Hugging Face 是一个专注于开源机器学习的平台,提供了一系列强大的工具和资源,帮助开发者和研究人员进行 AI 模型的开发、训练、部署与共享。它以强大的 Transformer 模型库和易用的 API 而闻名,广泛应用于自然语言处理(NLP)领域。Hugging Face 被视为 AI 模型界的 GitHub,其目标是让人们更方便地使用和开发 AI 模型。

Hugging Face 的主要功能

-

丰富的预训练模型 :Hugging Face 提供超过 50,000 个预训练模型,涵盖 BERT、GPT、T5、RoBERTa 等主流模型,支持多种任务,如文本分类、生成、问答、翻译等。

-

强大的开发工具 :

-

Transformers :支持多种预训练模型的开发和部署,提供灵活的接口,方便模型微调和自定义开发。

-

Datasets :用于加载和处理 Hugging Face Hub 上的数据集及本地数据集。

-

Tokenizers :将文本转换成模型可以处理的数字形式(token id 序列)。

-

Gradio :用于快速构建和分享 AI 模型的可视化界面。

-

-

模型托管与共享 :Hugging Face Hub 是一个集中化平台,用于模型与数据集的托管与分享,支持开发者构建机器学习应用及协作。

-

高效微调工具 :提供 PEFT 等工具,专门用于大语言模型的参数高效微调,帮助降低资源消耗。

-

多模态任务支持 :结合 NLP 和计算机视觉(如 CLIP、Vision Transformer),支持多模态任务。

Hugging Face 的使用步骤

-

注册账号 :访问 Hugging Face 官网(https://huggingface.co/),点击右上角的 “Sign Up” 按钮进行注册。

-

安装相关库 :通过以下命令安装 Hugging Face 的核心库:

pip install transformers datasets tokenizers其中,transformers库用于加载、使用、微调预训练模型;datasets库用于加载和处理数据集;tokenizers库用于文本分词。 -

加载预训练模型 :使用

transformers库中的AutoModel和AutoTokenizer类加载预训练模型和分词器。例如,加载 GPT-2 模型:Python from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "gpt2" model = AutoModelForCausalLM.from_pretrained(model_name) tokenizer = AutoTokenizer.from_pretrained(model_name) -

使用模型进行推理 :使用加载的模型和分词器创建 pipeline,进行文本生成等任务。例如:

Python from transformers import pipeline generator = pipeline(task="text-generation", model=model, tokenizer=tokenizer) output = generator("Hello, I am a language model,", max_length=50) print(output) -

微调模型 :对预训练模型进行微调,以适应特定任务。例如,使用 IMDb 影评数据集进行情感分析任务的微调:

Python from transformers import AutoModelForSequenceClassification, AutoTokenizer from datasets import load_dataset dataset = load_dataset("imdb") model_name = "bert-base-cased" model = AutoModelForSequenceClassification.from_pretrained(model_name, num_labels=2) tokenizer = AutoTokenizer.from_pretrained(model_name) inputs = tokenizer(dataset["train"]["text"][:10], padding=True, truncation=True, return_tensors="pt") outputs = model(**inputs) predictions = outputs.logits.argmax(dim=-1) -

部署模型 :将训练好的模型部署到 Hugging Face Hub 或其他平台,供他人使用。

Hugging Face 的产品价格

Hugging Face 提供了免费的模型托管和推理服务,用户可以免费使用其平台上的预训练模型进行开发和部署。此外,Hugging Face 还提供了一些付费服务,如专属算力资源、高级技术支持等,以满足企业用户的需求。

Hugging Face 的使用场景

-

自然语言处理 :广泛应用于文本分类、情感分析、机器翻译、问答系统等任务,帮助开发者快速构建语言处理应用。

-

多模态应用 :结合 NLP 和计算机视觉,支持图像描述生成、视频字幕生成等多模态任务。

-

音频处理 :支持语音识别、语音合成等任务,适用于需要音频处理的项目。

-

教育与研究 :为研究人员提供丰富的预训练模型和数据集,加速研究进程;为教育工作者提供教学资源和实践平台。

-

企业应用 :企业可以利用 Hugging Face 的模型和服务,快速开发和部署 AI 应用,提升业务效率。

相关导航

暂无评论...

浙公网安备33010202004812号

浙公网安备33010202004812号