AI Ping 是什么

AI Ping 是由清华系 AI Infra 领域创业公司清程极智推出的大模型服务性能评测与统一 API 调用平台。面对如今大模型(MaaS,Model-as-a-Service)快速增长、供应商和模型版本繁多的局面,AI Ping 应运而生,致力于为开发者、团队和企业提供客观、实时、科学的大模型服务评测与选型依据。通过长期持续监测、统一接口与智能路由等机制,AI Ping 化繁为简,将“挑模型、选服务商”的复杂流程简化为一站式操作,对于需要集成多个大模型服务或对性能/价格敏感的用户具有重要价值。

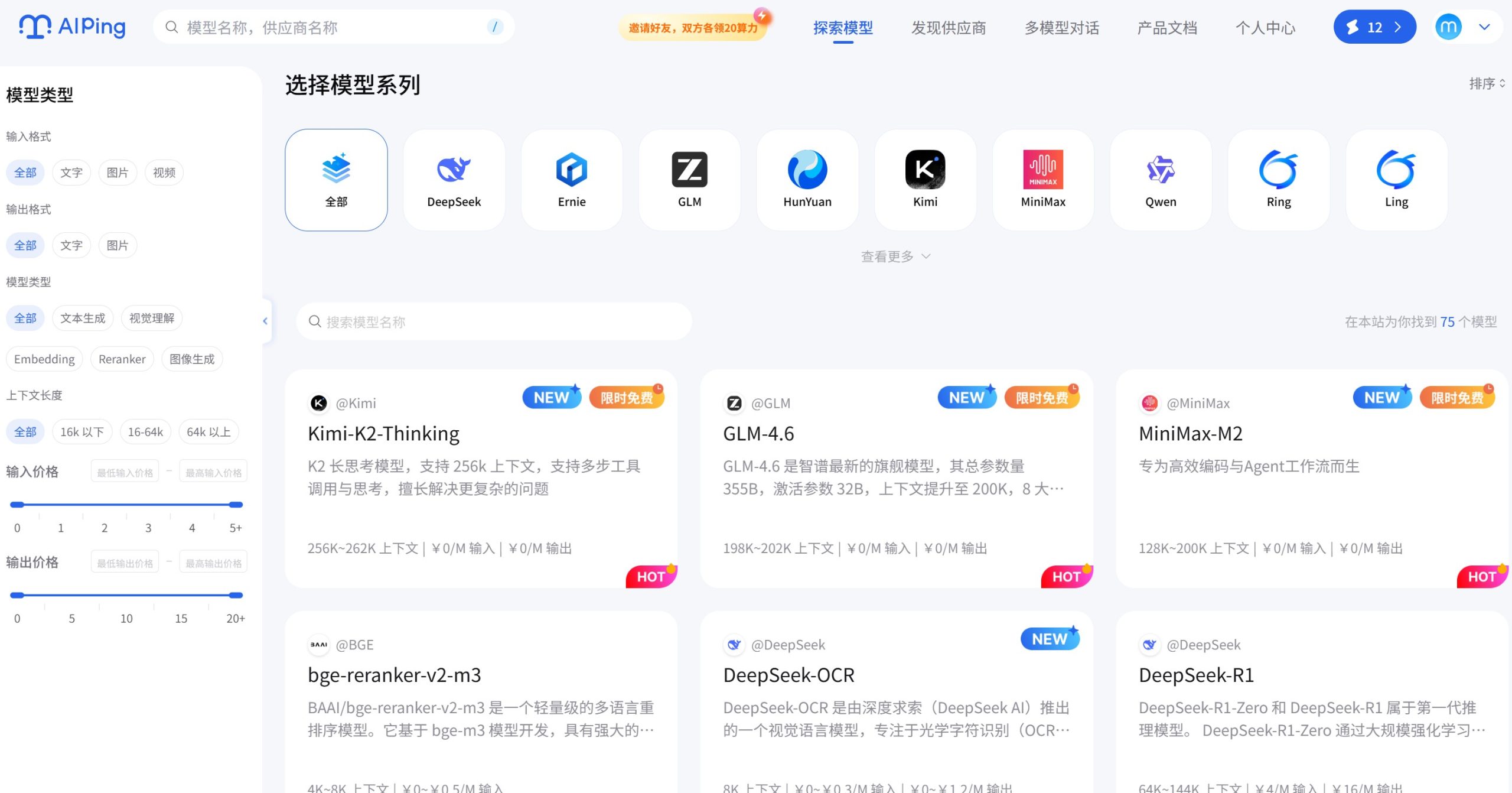

平台里面有免费模型,Kimi-K2、MiniMax-M2、GLM-4.6 这仨首月免费用,新用户注册可以领30元赠金,赠金可用于其他模型体验使用,

注册地址👉https://aiping.cn/

AI Ping 的主要功能

- 性能评测榜单:AI Ping 通过 7×24 小时持续监控,对接入的各大模型服务进行延迟、吞吐、可靠性等关键指标的评测,并生成性能排行榜。用户可以查看数十家供应商、数百个模型服务在不同时间段的真实运行数据,从而直观了解哪个模型服务在实际使用中表现更稳定、更高效。

- 统一 API 接口:不论后端服务商多少,只需接入 AI Ping 提供的标准 API 接口,就能访问平台内所有已集成的大模型服务。这样开发者只需一次集成,就能跨供应商调用,不必为每家服务商单独适配接口,极大降低接入复杂度。

- 智能路由调度:当用户发起请求时,AI Ping 根据实时监控数据(如延迟、吞吐、费用、可靠性等),自动将请求路由至最适合的供应商。这样既可以在高峰时保障吞吐和稳定性,也能在非高峰期选择性价比最高的服务,兼顾性能与成本。

- 模型/服务库与筛选系统:平台列出已集成模型服务的详细信息,包括上下文长度、最大输出长度、定价、供应商列表等参数,并支持基于这些维度进行筛选与排序。无论是追求输出速度、长上下文支持,还是性价比、稳定性,用户都能用筛选系统快速锁定适合项目需求的模型。

- 调用数据与成本透明:用户中心提供调用记录、Token 消耗量、费用构成等详细报表。通过查看每次 API 调用的真实消耗与支出,开发者可以更好地统计成本、优化预算、调整调用策略,避免盲目试错。

- 工具调用(Function/Tool Calling)支持:当模型返回结构化调用请求(如 JSON Schema 定义)时,AI Ping 支持与外部系统或工具并行/串行交互,实现功能编排与系统集成。对接像 OpenAI 格式或 Anthropic 格式定义的工具接口,可用于构建复杂业务逻辑或多步任务流程。

如何使用 AI Ping

- 访问官网并注册:首先通过网页浏览器访问 https://aiping.cn/ ,注册账号/登录,并获取 API Key。一般新用户可在控制台中看到可用模型列表与接入文档。

- 浏览性能榜单与模型列表:登录后,可先查看“性能榜单”或“模型列表”,浏览各模型服务的延迟、吞吐、历史稳定性等数据,也可根据上下文长度、价格、输出长度等条件筛选模型服务。

- 选择模型与供应商 / 启用智能路由:根据项目需求(如响应速度优先、成本优先、长上下文支持等),选择合适模型/服务,或启用智能路由模式,让平台自动为你匹配最优供应商。

- 发起 API 请求:通过统一 API 接口发送请求,携带你的 API Key 和请求参数(如模型名、上下文、prompt 等),即可获得模型输出。若模型返回工具调用请求 (Function Calling),也可以使用规范处理工具调用。

- 查看调用记录与成本消耗:在用户中心,可查看每次调用的 Token 消耗、所用供应商、费用构成等详细统计数据,用于后续分析和优化调用策略。

- 调整 & 优化调用方案:基于调用数据和业务需求,灵活调整模型、供应商或开启/关闭智能路由,以达到性能与成本的最佳平衡。

AI Ping 的应用场景

- AI 项目开发与集成:无论是对话系统、内容生成、自动化处理、数据分析等,只要需要调用大模型服务,就可以通过 AI Ping 快速选型、统一接口调用,极大简化接入流程。

- 多模型 / 多供应商切换场景:对于希望避免绑定单一供应商、希望灵活切换不同模型服务的中小团队或初创公司,AI Ping 提供统一入口和智能路由,是非常方便的集成入口。

- 性能与成本对比评估:团队在选型阶段,需要对不同模型服务进行性能、价格、稳定性等多维度对比,通过 AI Ping 的榜单和筛选功能,可以科学评估、决策更稳妥。

- 研究与实验场景:学术研究者或 AI 研究人员需要对多个模型进行对比测试、分析性能差异、基准测试等,AI Ping 提供的数据和服务方便用于研究和对照实验。

- 工具/系统集成与自动化:当大模型不仅是“聊天 / 生成”工具,而是系统的一部分(例如自动化流程、工具调用、后台服务等),AI Ping 的 Function-Calling 支持和稳定性能表现非常适合生产环境集成。

- 预算敏感型业务:对于对费用敏感的项目(如创业公司、小团队、长期运行服务等),AI Ping 通过透明成本统计与智能路由,可以有效控制调用成本,提高性价比。

和其他 AI 工具相比,AI Ping 有哪些优势?

这里将以 OpenAI(及其 API 服务)和国内某些单一供应商大模型服务作为对比对象。

- 功能差异:与直接使用单一供应商 / 单一模型 API 不同,AI Ping 提供评测榜单、统一接口、智能路由、调用统计、Function Calling 等全套功能,涵盖从选型、调用到成本监控的完整流程。相比于仅提供模型 API 的工具,AI Ping 更像是“模型服务中间层 + 评价系统 + 管理平台”,降低了用户的选型成本和集成复杂度。

- 价格与性价比:单一供应商 API 的定价可能不稳定,也可能因性能波动导致用户体验不一致。而 AI Ping 通过透明计费体系与按量 / 订阅 /团队/企业方案,为用户提供灵活付费选择,并能通过智能路由在不同供应商间动态切换,平衡性能与成本。从性价比角度来看,对于需要多模型、多供应商调用的用户,AI Ping 往往比直接锁定单一供应商更划算。

- 操作界面与用户体验:直接供应商 API 往往界面分散、文档不统一、调用方式各异;而 AI Ping 的界面设计简洁、逻辑清晰,文档统一、接口标准化,并且通过性能榜单与可视化图表展示数据,开发者不必深入了解各家后台机制就能快速判断优劣,学习成本较低,适合不同技术背景的用户。

- 定制与扩展性:AI Ping 支持 Function / Tool Calling,通过 JSON Schema 与标准接口与外部系统集成,非常适合构建复杂业务流程、自动化系统或工具链。而传统模型 API 往往只支持简单 prompt → response,不方便大规模系统集成。对于需要复杂业务逻辑或工具调用的项目,AI Ping 的扩展性优势明显。

常见问题 FAQ

- AI Ping 是否直接提供聊天 / 生成服务?

答:不,它本身不提供聊天、绘图、生成等 AI 功能,而是作为“大模型服务聚合平台 + 评测平台 + 调用入口”,为你调用第三方供应商的大模型服务。你调用的是供应商提供的模型,而 AI Ping 提供的是统一接口、路由与性能/成本评估。 - 我如果对延迟或吞吐有特殊要求,可以指定供应商吗?

答:可以。AI Ping 除了默认的智能路由,也支持手动筛选供应商、手动指定模型服务,以满足你对延迟、输出速度、成本等的个性化需求。 - 如何查看调用成本与 Token 使用情况?

答:登录后进入用户中心,在调用记录或统计报表里可以查看每次请求消耗的 Token 数量、费用构成、供应商信息等,便于你分析投入产出、优化调用策略。 - 适合哪些用户使用 AI Ping?

答:适合需要频繁调用大模型 API 的开发者、团队或企业;需要对比多个模型或供应商性能/价格的项目;希望简化集成流程、多模型混合调用或系统集成(如工具调用、自动化流程等)的用户。 - 是否有免费或试用额度?

答:对于新用户或测试项目,有些模型与服务可能提供免费额度或赠金/试用机制,以便用户体验与评估。 - 如果某供应商服务不稳定,AI Ping 会自动切换吗?

答:如果你开启了智能路由功能,AI Ping 会根据实时监控数据,在服务不稳定或不符合预期时,将请求转发至其他更优供应商,以保障性能和稳定性。

总结:AI Ping 是否值得推荐?

总的来看,AI Ping 的核心价值在于——它不只是一个简单的大模型 API 提供平台,而是一个集评测、选型、调用、监控于一体的“大模型服务中枢”。对于开发者、团队、企业,尤其是那些需要调用多个模型服务、希望灵活切换供应商、追求性能稳定与成本可控的人来说,它大大降低了接入复杂度和运营风险。通过统一 API、智能路由、透明计费与性能榜单,你可以快速判断哪个模型/服务商最适合自己的项目,也能根据调用数据优化成本与性能。相比于传统单一供应商 API,AI Ping 在功能完整性、灵活性、性价比和扩展性方面优势明显。如果你正在寻找一个稳健、灵活、专业的大模型服务接入方案,AI Ping 绝对值得考虑。

相关导航

暂无评论...

浙公网安备33010202004812号

浙公网安备33010202004812号