Qwen3.5是什么

Qwen3.5是阿里巴巴通义千问团队正式发布的原生多模态大模型,也是新一代开源智能模型的代表。该模型首发版本Qwen3.5-397B-A17B采用创新的混合架构,将线性注意力(Gated Delta Networks)与稀疏混合专家(MoE)结合,总参数达3970亿,但每次推理仅激活17亿参数,实现以低计算资源完成高性能推理。Qwen3.5支持文本、图像和视频的统一处理,通过早期视觉-语言融合以及M-RoPE和3D位置编码技术,实现跨模态理解与推理。语言覆盖从119种扩展至201种,并在多项权威评测中表现出色,为开发者提供高性价比的开放模型服务。

Qwen3.5的主要功能

- 原生多模态理解:统一处理文本、图像、视频,通过早期视觉-语言融合实现跨模态推理和内容生成。

- 智能体能力:支持工具调用、任务规划与执行,可集成Agent进行自动化任务,表现优异于BFCL-V4等评测。

- 高效推理架构:采用Gated DeltaNet+MoE混合设计,397B参数仅激活17B即可完成顶级性能推理,显存使用显著降低。

- 长上下文处理:支持最高1M上下文长度,处理超长文本或视频场景时保持高解码吞吐量。

- 多语言支持:覆盖201种语言与方言,词表扩展至25万,编码效率提升10–60%,可直接进行多语言对话与生成。

- 代码生成能力:支持多语言编程、调试及复杂项目开发,可辅助软件开发与代码重构。

- 视觉识别:提供细粒度图像理解、目标检测、OCR文档解析及空间关系推理能力。

- 搜索增强:集成BrowseComp等搜索Agent,实现联网信息检索与整合,为智能问答和内容生成提供实时数据支持。

Qwen3.5的技术原理

- 混合注意力架构:融合Gated DeltaNet线性注意力与稀疏Gated Attention,实现自适应计算资源分配,提高长序列推理效率。

- MoE稀疏激活:总参数397B仅激活17B(约4.3%),通过共享专家和路由专家组合降低推理成本,同时保持模型性能。

- 门控机制优化:采用head-specific sigmoid门控替代传统softmax注意力,实现更灵活的计算分配,该技术获2025年NeurIPS最佳论文奖。

- 原生多模态融合:使用M-RoPE与3D位置编码将时空信息嵌入模型,实现文本、图像、视频的统一处理。

- 异构训练框架:视觉与语言组件解耦并行,结合稀疏激活实现跨模块计算重叠,训练吞吐接近纯文本模型基线。

- FP8混合精度:对激活、MoE路由与GEMM采用低精度计算,敏感层保留BF16精度,显存降低50%以上。

- 异步强化学习:构建可扩展异步RL框架,支持全尺寸模型训推分离与动态负载均衡,整体加速3–5倍。

- 跨模态早期融合:通过视觉-语言早期融合机制,实现多模态信息在编码阶段统一表达,提升理解与推理能力。

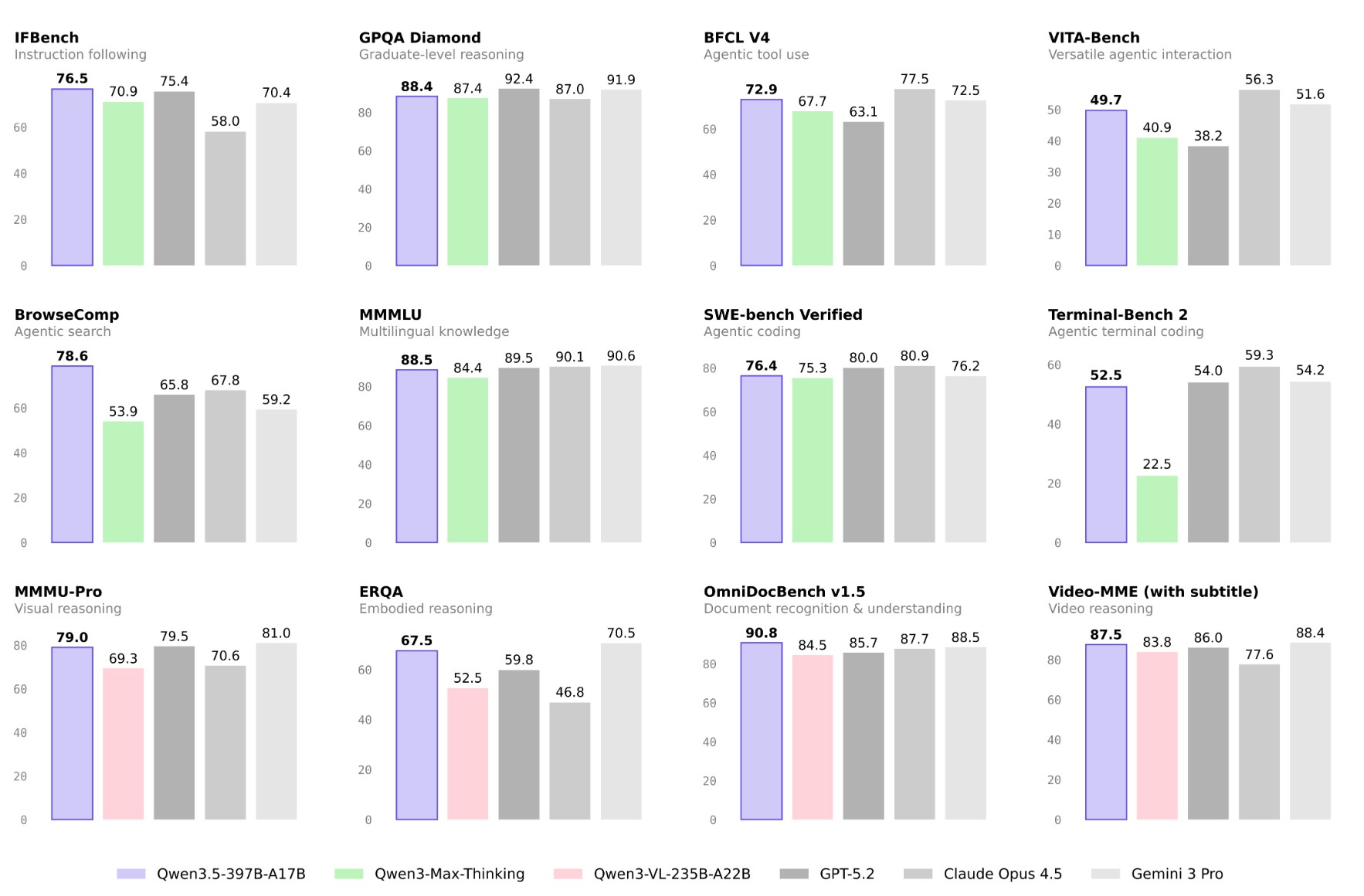

Qwen 3.5 的性能表现

- 指令理解能力:在 IFBench 测试中取得 76.5 分,体现出较强的指令跟随与复杂任务拆解能力,适合多步骤交互场景。

- 高阶推理能力:在 GPQA Diamond(研究生级推理)中达到 88.4 分,显示出稳定的逻辑分析与综合推理表现。

- 智能体工具调用:BFCL V4 得分 72.9,BrowseComp 达到 78.6,说明在检索、工具协同与任务执行方面具备良好能力。

- 多语言与知识覆盖:MMMLU 得分 88.5,覆盖多语种知识问答,适合全球化应用场景。

- 代码与终端能力:SWE-bench Verified 为 76.4,Terminal-Bench 2 为 52.5,体现一定的工程与终端交互能力。

- 多模态与视觉理解:在 MMMU-Pro、OmniDocBench v1.5 与 Video-MME(含字幕)等测试中分别取得 79.0、90.8 与 87.5 分,展现出较强的视觉推理与文档理解能力。

如何使用Qwen3.5

- 网页端体验:访问Qwen Chat或下载千问APP/PC客户端,直接输入文字或上传图片/视频进行多模态交互,支持实时对话与内容生成。

- API调用:通过阿里云百炼平台获取API密钥,每百万Token仅需0.8元接入模型服务,实现高性价比的程序化调用。

- 本地部署:从HuggingFace或魔搭社区下载Qwen3.5-397B-A17B模型权重,可在本地或私有云环境部署运行,适合对数据隐私有高要求的场景。

- 智能体开发:利用模型原生Agent能力,结合工具调用接口开发自动化任务执行、数据分析、搜索增强等应用。

- 多语言应用:直接输入201种支持语言中的任意一种进行对话,无需额外配置翻译模块,适用于全球化场景。

- 长文档处理:上传超长文本、PDF或视频内容,模型自动处理高达1M上下文的复杂推理任务,适合科研、法律、教育等应用。

Qwen3.5的项目地址

- Hugging Face模型库:https://huggingface.co/collections/Qwen/qwen35

- GitHub仓库:https://github.com/QwenLM/Qwen3.5

- 技术论文:通义千问官方论文与技术报告(可在阿里云学术资源或会议论文库获取)

- 网页版访问:Qwen Chat在线交互入口,支持多模态体验

Qwen3.5的应用场景

- 智能客服:支持201种语言的多轮对话与复杂问题解答,可用于企业客服系统、跨国服务中心及在线支持平台。

- 内容创作:辅助文案撰写、视频脚本生成、多语言翻译及本地化内容适配,提升创作者效率。

- 代码开发:提供代码生成、调试、重构服务,支持Python、Java、C++等多种语言,适合复杂软件项目开发与维护。

- 视觉分析:实现图像识别、目标检测、文档OCR解析及视频内容理解,支持细粒度视觉问答和多模态分析。

- 智能体自动化:构建自动化工作流,执行数据分析、信息检索、任务调度等Agent任务,减少人工干预。

- 教育辅助:支持多语言教学、作业批改、个性化学习路径规划与知识问答,适合教育机构和在线学习平台。

- 科研与文档分析:处理长文档、PDF和视频材料,实现自动摘要、知识抽取及跨文档推理。

- 企业智能助手:结合内部数据构建知识库,实现智能搜索、会议纪要生成、报表分析等企业应用。

- 跨境信息服务:多语言理解与生成能力使模型适合全球化市场信息整合、新闻摘要与舆情监测。

Qwen3.5的常见问题解答(FAQ)

- Q:Qwen3.5适合哪些用户或使用人群?

答:Qwen3.5适合开发者、科研人员、企业用户及内容创作者,尤其需要处理多模态数据、长上下文文本或跨语言任务的人群。 - Q:Qwen3.5是通用模型还是偏向某一领域?

答:Qwen3.5属于通用大模型,同时具备多模态和多语言能力,可适用于自然语言处理、视觉分析、代码生成等多个领域。 - Q:Qwen3.5是否开源?采用什么开源协议?是否支持商用?

答:Qwen3.5-397B-A17B模型权重开源,开发者可从HuggingFace或魔搭社区获取。具体商用许可需参照官方开源协议与阿里云百炼服务条款。 - Q:使用Qwen3.5对算力或硬件环境有何要求?

答:本地部署需GPU集群或高显存服务器,API调用可通过云端服务完成,单次推理仅激活17B参数,大幅降低显存需求。 - Q:与其他通用大模型相比,Qwen3.5的核心优势是什么?

答:Qwen3.5在多模态理解、长上下文处理、跨语言支持及高效推理方面表现突出,同时开源并具备低成本API接入,性价比较高。 - Q:个人用户或初学者能使用Qwen3.5吗?

答:个人用户可通过网页版或APP体验模型功能,学习和实验多模态交互;本地部署和开发复杂应用则适合有一定技术基础的用户。 - Q:Qwen3.5主要应用场景和使用边界有哪些?

答:模型适合智能客服、内容创作、代码生成、视觉分析、教育辅助等场景,但对于极端专业领域或安全敏感数据,仍建议结合人工审核。

© 版权声明

本站文章版权归AI工具箱所有,未经允许禁止任何形式的转载。

相关文章

暂无评论...

浙公网安备33010202004812号

浙公网安备33010202004812号