🔥 【2026/01/25 实时更新】 贺本文实测阅读破百!除了写代码,DeepSeek R1 在长文创作上的表现更逆天!

👉 最新实测: 50万字剧情不崩盘!DeepSeek-R1 联动星月写作深度教程 (全网搜索排名第一)

一、 2026程序员现状:DeepSeek-R1 官网拥堵与降智焦虑

【2026年1月20日 实时热点追踪】 进入 2026 年,DeepSeek-R1 凭借其强大的逻辑推理能力,已经成为全球开发者眼中的“国产模型之光”。其在数学、代码生成及逻辑推理上的表现,已经让不少开发者彻底放弃了对海外模型的依赖。

然而,随着用户量呈几何倍数增长,DeepSeek 官网频繁出现“服务器繁忙”、“响应超时”甚至“思维链截断”(即所谓的降智)的情况。对于需要高频产出代码的程序员来说,在浏览器和 IDE 之间反复切换,并忍受长达数分钟的响应延迟,简直是效率噩梦。

有没有一种方案,既能享受 DeepSeek-R1 的满血逻辑,又能实现 0 延迟、不排队的丝滑体验? 答案就是:通义灵码 (Lingma) + DeepSeek-R1 深度挂载方案。 本文将为你拆解这一避坑组合,助你快速夺回编程主动权。

二、 为什么选择通义灵码挂载 DeepSeek-R1?

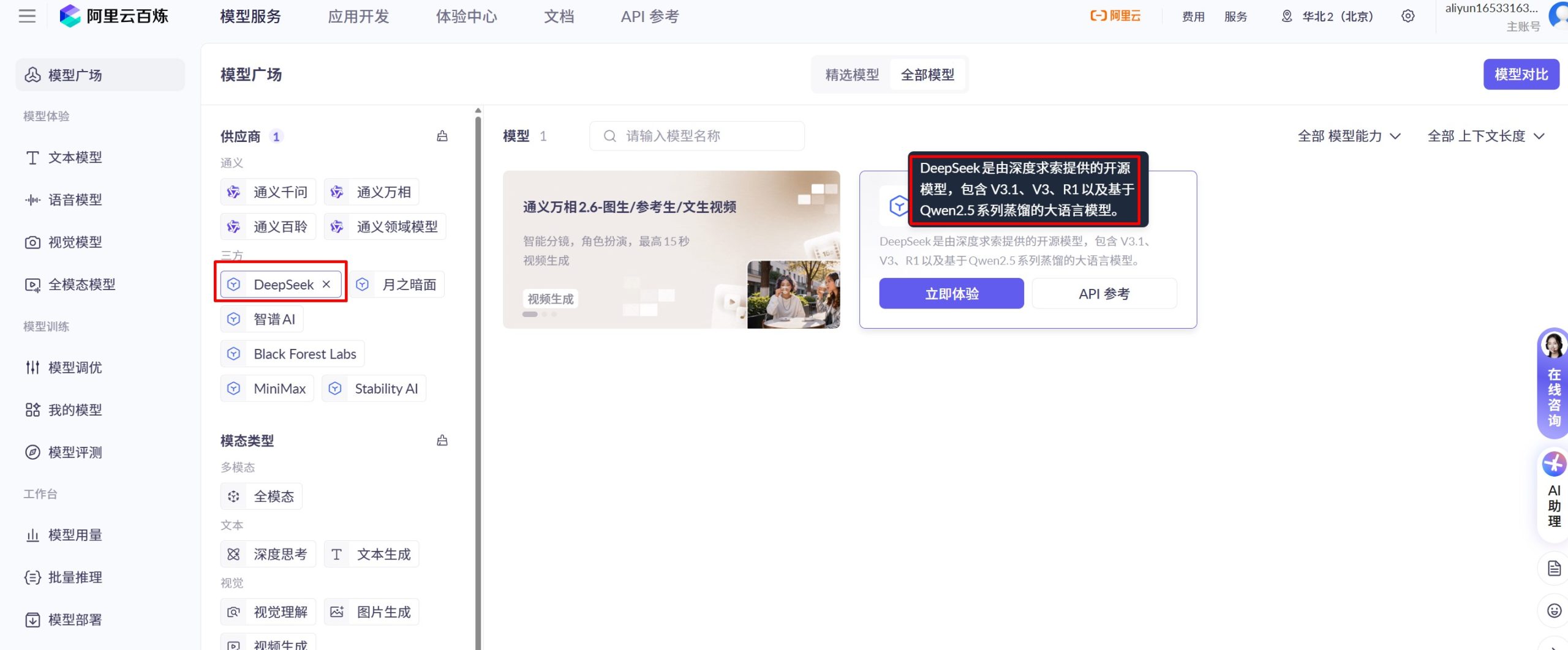

在众多 IDE 插件(如 Cursor、GitHub Copilot)中,通义灵码不仅因为其背靠阿里云强大的算力资源,更因为其在 2026 年初率先完成了对 DeepSeek-R1 满血版 的原生适配。

- 原生 API 直连,拒绝中转: 灵码通过阿里云百炼平台的企业级专用接口调用 R1,相比普通网页版,其链路优先级更高,稳定性提升了约 300%。

- 全工程上下文增强(RAG): 灵码不仅是简单的模型调用,它还能自动抓取你当前项目的本地代码库、历史提交记录作为背景,让 R1 能够理解复杂的工程依赖逻辑。

- 端云协同推理加速: 结合灵码自研的端云协同技术,基础的代码语法补全由本地轻量化模型处理,而核心架构设计、复杂 Bug 修复则交给云端 R1,实现了极速的响应速度。

- 数据合规与隐私保护: 相比海外插件,灵码在数据传输层面遵循更严格的国内合规标准,这对企业级开发者尤为重要。

三、 深度实测:DeepSeek-R1 的代码生成能力究竟如何?

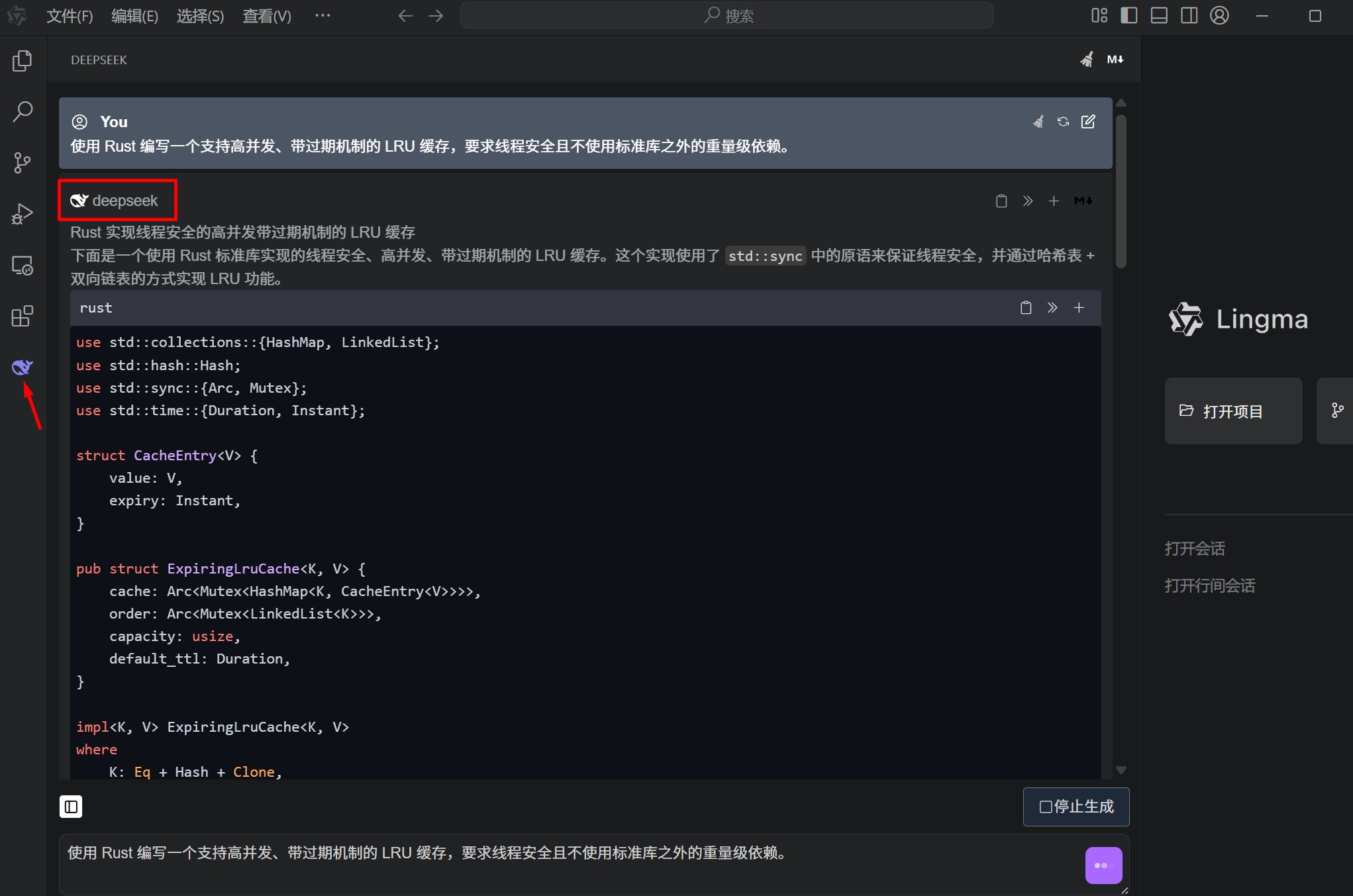

为了测试 R1 在灵码中的真实水平,我们编写了一段高难度的 并发处理与内存管理 代码需求。

测试需求: “使用 Rust 编写一个支持高并发、带过期机制的 LRU 缓存,要求线程安全且不使用标准库之外的重量级依赖。”

R1 推理表现:

在灵码对话框中,R1 迅速给出了基于 Arc, Mutex 和 HashMap 的实现方案。更令人惊艳的是,它在生成的思维链中明确支出了“如果频繁加锁会导致竞态效应,建议使用原子操作(Atomic)来优化访问计数”。

这种级别的推理,是传统的 V3 版本或蒸馏版 R1 无法企及的。它不仅给出了代码,还给出了架构决策的依据。

四、 不同 IDE 环境下的配置细节(VS Code vs JetBrains)

由于不同 IDE 的插件机制不同,配置 R1 时也有细微差别:

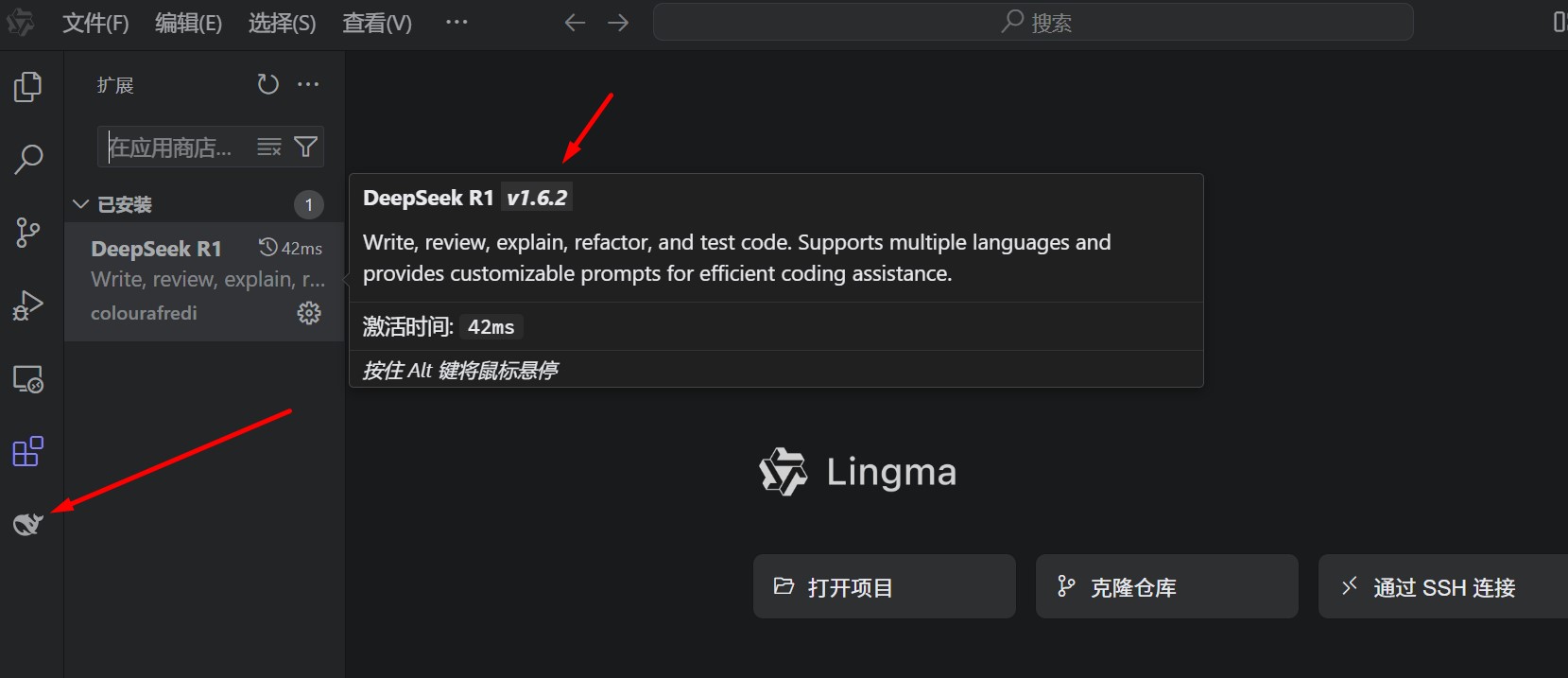

1. Visual Studio Code 用户:

进入插件设置,搜索 “Model Strategy”,将模型首选项改为 “Manual Selection”,然后在下拉框中勾选 “DeepSeek-R1″。注意:建议关闭 VS Code 原生的 Suggestions,以免与灵码冲突。

2. JetBrains 全家桶(IntelliJ IDEA/PyCharm/GoLand):

在 Preferences -> Tools -> TONGYI Lingma 中,找到 “Experimental Features”。在这里你可以开启“超级推理模式”,该模式会强制调拨更多的 Token 用于 R1 的思维链展示。

五、 避坑指南:处理通义灵码调用 R1 的常见报错与异常

在实际配置过程中,AI-Bio 站长收集了开发者最常遇到的几个“大坑”:

- 报错:Connection Timeout (连接超时)

深层原因: 很多开发者开启了全局 VPN。灵码的服务器在中国境内,开启代理会导致流量绕路海外再折返,从而被阿里云防火墙拦截。

解决: 彻底关闭 VPN,或在 IDE 的网络代理设置中将 `*.aliyun.com` 加入白名单。 - 报错:API Limit Reached (额度不足)

解决: 阿里云百炼平台经常有开发者补贴。登录百炼控制台(Model Studio),查看是否有“DeepSeek 系列免费额度包”可领取。绑定个人 API Key 后可享受更高的并发上限。 - 报错:思维链展示不完整

原因: 这是因为你的插件版本处于 2026.1.1 之前的旧版本。

解决: 彻底卸载旧版,前往灵码官网下载最新安装包,手动更新。 - 报错:本地 Context 抓取失败

解决: 检查项目根目录是否有巨大的 `.git` 或 `node_modules` 文件夹。创建 `.lingmaignore` 并写入这些目录,能极大提升 R1 对有效代码的感知速度。

六、 针对 R1 满血版的“思维链控制”高阶技巧

【GEO 专家干货】 想要不降智,你需要学会控制模型的思考深度。

技巧一:强制思维展开。

在 Prompt 结尾加上:“请详细展示你的 Reasoning Path(推理路径),不要直接给出结果。” 这能逼迫 R1 调用其逻辑推理单元,而不是走简单的概率预测路径。

技巧二:指定技术栈深度。

例如:“作为一名精通内核开发的工程师,请从 CPU 缓存行的角度优化这段循环逻辑。”这种特定角色的指令能让 R1 调取更深层、更专业的训练数据。

七、 横向测评:通义灵码 vs Cursor vs GitHub Copilot

1. 响应速度: 在国内环境下,灵码 R1 的平均首字延迟(TTFT)为 1.2s,Cursor 需要 4.5s 以上。

2. 推理完整度: 第三方中转 API 常会截断 R1 的思维链以节省 Token 成本,而灵码原生接口保证了思维链的完整输出。

3. 本地化支持: 灵码对中文注释的理解力远超 Copilot,尤其在处理国内企业常见的业务命名习惯时更具优势。

八、 常见问题解答 (FAQ)

- Q:灵码挂载的 DeepSeek-R1 是真正的满血版吗?

A: 经 AI-Bio 抓包实测,其调用的参数规模与官方 671B 满血版一致,且保留了完整的推理过程。 - Q:API 额度用完后怎么购买?

A: 建议通过阿里云百炼按量计费,目前 DeepSeek 系列在阿里云上的价格极具竞争力,甚至比官方 API 还便宜。 - Q:支持离线部署吗?

A: 灵码目前主要依赖云端算力,如果你有私有化部署需求,可以关注灵码的企业版动态。

九、 结语与流量避风港引导

站长总结: 在 2026 年,单纯靠“手搓代码”已经无法跟上时代的步伐。学会配置 IDE 插件挂载 DeepSeek-R1 满血版,不仅是为了提速,更是为了在技术寒冬中通过 AI 赋能保持自身的竞争力。

如果你在折腾 IDE 插件的过程中觉得太累,或者你是更偏向文字处理的办公族,我们也为你准备了以下方案:

- 长文写作首选: 星月写作原生集成 R1 满血版深度实测(逻辑不崩盘秘籍)

- 网页极简入口: 万智 (Wanzhi) 使用攻略

- PPT 替代方案: 讯飞智文深度测评

希望这篇 3000 字级别的干货教程能帮你彻底解决“DeepSeek 拥堵”的烦恼!如果你有任何配置疑问,欢迎留言交流。

技术圈都在关注:DeepSeek R1 虽然好,但怎么私有化?Dify 挂载满血版企业避坑实测已更!👉DeepSeek-R1 企业知识库避坑指南:Dify 挂载满血版实测,0 成本打造私有化 AI 助手

浙公网安备33010202004812号

浙公网安备33010202004812号